在近日举办的2024世界人工智能大会(WAIC)上,人工智能领域再次成为全球瞩目的焦点。本届展会堪称一场技术的盛宴,超过30款大模型隔空“斗法”,大算力AI芯片密集“炫技”,共同勾勒出人工智能应用软件开发的壮丽图景。

一、 百花齐放:大模型竞逐应用新高度

展会上,来自科技巨头、顶尖高校及创新型企业的超过30款大模型同台竞技,标志着人工智能技术已从“单点突破”进入“群体跃升”阶段。这些模型不仅涵盖了自然语言处理、多模态理解、代码生成等传统优势领域,更在垂直行业的深度应用上展现出惊人潜力。

- 通用底座持续夯实: 以GPT、文心一言、通义千问等为代表的通用大模型,在逻辑推理、创造性内容生成和复杂任务处理能力上再攀新高,其理解与交互的“人性化”程度令人惊叹,为上层应用提供了更强大、更易用的基础能力。

- 垂直领域深度渗透: 医疗大模型能解读影像、辅助诊断并生成个性化健康方案;金融大模型可进行智能投研、风险控制和合规审查;工业大模型则赋能智能制造,实现生产流程的优化与预测性维护。这些垂直模型正从“演示demo”走向“实战系统”,切实解决行业痛点。

- 轻量化与场景化成为趋势: 除了追求参数规模的“巨无霸”模型,更多专注于特定场景、对算力需求更友好的轻量级模型和边缘侧模型受到关注,它们让高性能AI能够部署在手机、汽车、物联网设备等更广泛的终端上,加速了AI的普惠化进程。

二、 硬核基石:大算力AI芯片驱动创新引擎

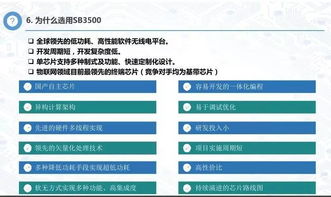

大模型的蓬勃发展与激烈竞争,其背后离不开算力这一核心驱动力。本届WAIC上,国内外芯片厂商密集展示了最新一代的大算力AI芯片及解决方案,上演了一场“硬实力”的比拼。

- 训练芯片追求极致性能: 为满足千亿乃至万亿参数模型的训练需求,新一代AI训练芯片在算力密度、内存带宽和互联技术上实现重大突破,力图将训练周期从数月缩短至数周甚至数天,极大降低了AI创新的时间和成本门槛。

- 推理芯片聚焦能效与成本: 面对海量的模型部署与推理需求,专用推理芯片在保证高性能的将功耗和成本控制作为关键指标,推动了AI应用在云端和边缘端的大规模商业化落地。

- 软硬一体生态构建护城河: 领先的芯片厂商不再局限于提供硬件,而是构建起从芯片、计算框架、模型库到开发工具的完整软硬件协同生态,帮助应用开发者更高效地释放硬件潜能,简化开发流程。

三、 融合共生:应用软件开发的范式变革

大模型与AI芯片的飞速进步,正在深刻重塑人工智能应用软件开发的全流程,为开发者带来前所未有的机遇与挑战。

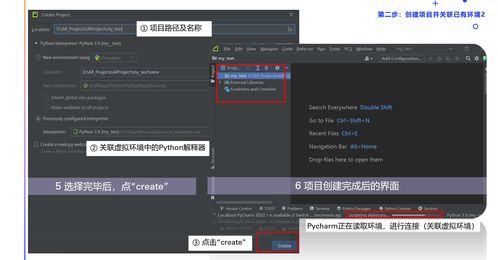

- 开发门槛显著降低: 借助成熟的云上AI平台和模型即服务(MaaS)模式,开发者无需从零开始训练大模型,即可通过API调用、微调(Fine-tuning)或提示词工程(Prompt Engineering)等方式,快速将顶尖的AI能力集成到自己的应用中,聚焦于业务逻辑与用户体验的创新。

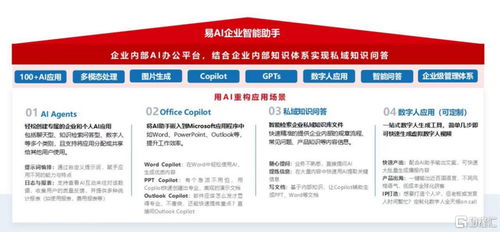

- “AI原生应用”成为新焦点: 开发范式正从“+AI”(为现有软件添加AI功能)转向“AI+”(以AI为核心思维重新设计应用)。能够充分发挥大模型理解、生成与推理能力的全新应用形态,如智能体(AI Agent)、高度个性化的虚拟助手、沉浸式内容创作工具等,成为创新热点。

- 全栈优化与工程化挑战凸显: 要打造稳定、可靠、高效的AI应用,开发者需要关注从模型选择与优化、算力资源配置、数据管道设计,到系统部署、监控与持续迭代的全栈能力。性能、成本、安全与隐私的平衡成为工程化落地的关键。

2024WAIC展会如同一扇窗口,清晰展现了人工智能技术从底层硬件、核心模型到上层应用的协同爆发态势。三十余款大模型的“群雄逐鹿”与AI芯片的“硬核竞赛”,共同为人工智能应用软件开发铺设了高速跑道。成功的AI应用将不再仅仅依赖于单一的算法优势,而是对技术整合能力、行业理解深度、工程化水平以及商业洞察力的综合考验。一个由强大算力支撑、智能模型驱动、创新应用繁荣的AI新生态,正在加速形成。